○ Training instability

- GAN은 많은 기대를 받고 있는 모델이지만 아직 여러 가지 한계점도 존재한다. 앞서 소개한 많은 모델이 GAN의 학습을 안정화시키기 위해 노력했지만, 아직도 GAN을 실제로 적용하려 할 때 가장 큰 걸림돌은 학습이 어렵다는 점이다. GAN 학습이 잘 되기 위해서는 서로 비슷한 수준의 생성자와 구분자가 함께 조금씩 발전해야 한다. 그런데 한쪽이 너무 급격하게 강력해지면 이 관계가 깨져버려서 GAN의 학습이 이루어지지 않는다. 경찰이 너무 강력하면 위조지폐범의 씨가 말라버리는 것이다.

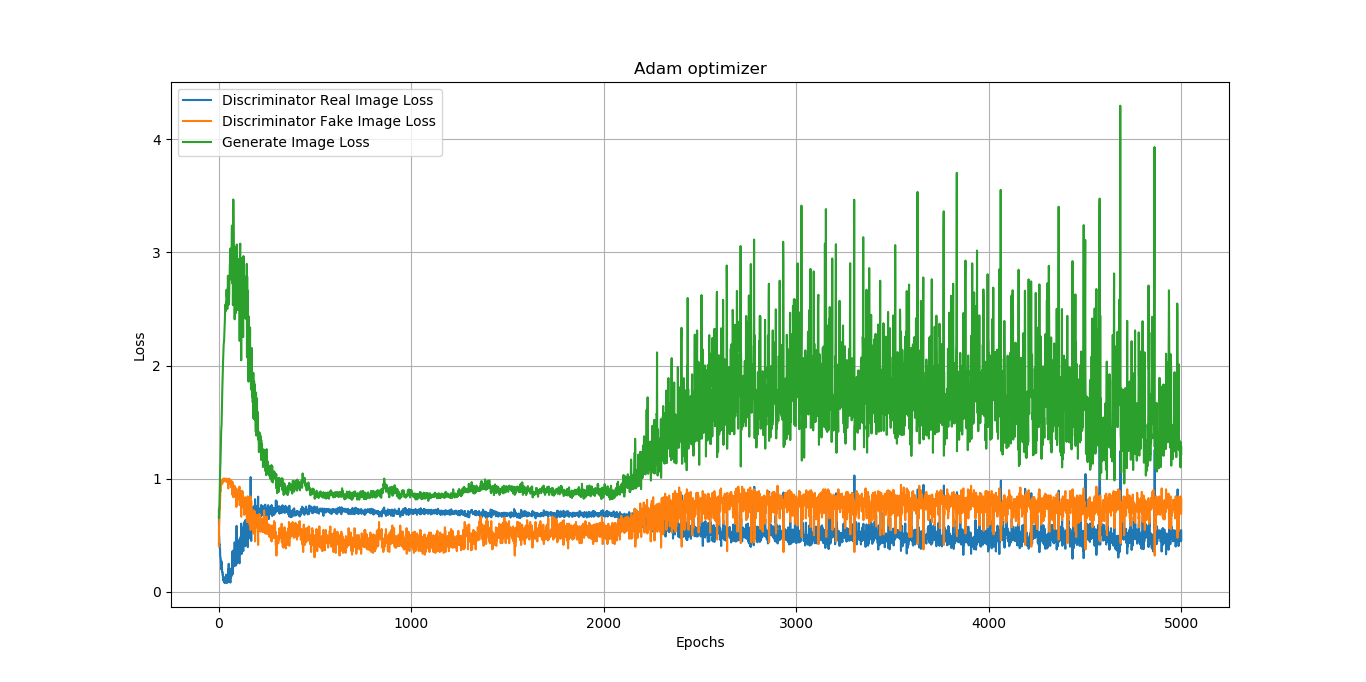

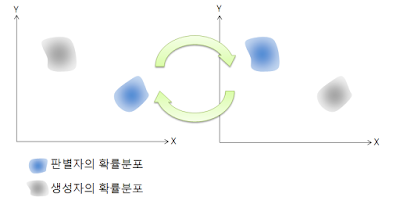

- GAN은 generator와 discriminator가 서로가 서로를 속이는 과정에서 generator가 data distribution에 근사하는것을 목적으로 한다. 하지만, 번갈아가면서 업데이트를 진행하는 특성상 generator가 좋아지면 discriminator도 좋아지고, discriminator가 좋아지면 generator도 좋아지고, 서로가 서로의 분포에 근사해가면서 끝나지않는 숨바꼭질을 무한히 반복하게 된다. 이로인해 discriminator, generator 모두 서로 자리를 바꾸어가며 쫓아다니게 되고, global optimum에 수렴하지 못하게 된다. 이런 현상을 oscillation이라고 한다.

○ Mode Collapse

- GAN이 제대로 학습을 하지 못하고 있을 때 나타나는 모드붕괴(Mode Collapse)라는 현상이 있다. 이는 생성자가 다양한 이미지를 만들어내지 못하고 비슷한 이미지만 계속해서 생성하는 경우를 뜻한다. GAN을 학습시킬 때는 이런 모드 붕괴 현상이 벌어지지 않는지, 생성자와 구분자 중 한 쪽이 너무 강해지지 않는지 유의해야 한다.

- 위의 예시는 MNIST data set을 가지고 훈련된 결과물인데요, 첫 번째 줄은 model collapse 문제를 해결하기 위해 만들어진 unrolledGAN 의 결과물이고, 두 번째 줄은 vanilla GAN의 결과물이다. 생성한 샘플이 다양하게 되지 못하고 한두 가지 샘플과 비슷한 결과물만 생성되는 것을 볼 수 있다.

○ GAN의 학습이 너무 어려울 때는 ‘VAE(Variational Auto-Encoder)’라는 모델을 쓰는 것도 고려해 볼 수 있다. VAE는 생성 모델이라는 목적은 GAN과 같지만, GAN과는 다른 방식으로 동작한다. VAE는 GAN보다 학습이 좀 더 안정적이라는 점이 장점이지만, 흐릿한 이미지가 생성되는 블러(Blur) 현상이 있다고 알려져 있다.

○ GAN의 또 다른 한계점은 아직 텍스트를 생성하는 데는 적용하기 어렵다는 점이다. 이미지나 음성 분야에서는 GAN의 성공 사례가 많이 있지만, 영어나 한국어 같은 자연어를 생성하는 문제에는 GAN의 성공 사례를 찾아보기 어렵다. 이는 텍스트가 이미지와 달리 불연속적이기 때문이다. 이미지는 실수값인 픽셀로 이루어져 있으므로 미분을 통해 조금씩 값을 바꿔보며 개선해 나갈 수 있다. 하지만 텍스트는 단어로 이뤄져 있기 때문에 이런 방식이 불가능하다. 물론 GAN으로 텍스트를 생성하려는 시도가 없었던 것은 아니지만, 아직 뚜렷한 성과는 내지 못하고 있다.

이 글의 내용 및 그림, 사진 등의 콘텐츠는 작성자에게 저작권이 있습니다.

이를 무단으로 복제, 수정, 배포하는 행위는 불법이며, 관련 법률에 의해 엄격하게 제재될 수 있습니다.

작성자의 동의 없이 이 콘텐츠를 사용하는 경우, 민사 및 형사상의 책임을 물을 수 있습니다.

Copyright. 우리의인공지능항해 All rights reserved.

'인공지능(LLM 구축) > AI 및 ML 알고리즘 소개' 카테고리의 다른 글

| Deep Learning 인공지능(AI) 시대 CPU의 발전 방향은? (2) | 2024.01.23 |

|---|---|

| 최신 기술 동향과 함께 알아보는 Advanced GAN (2) | 2024.01.22 |

| GAN 모델의 전문적인 증명 분석 (0) | 2024.01.22 |

| GAN 동작 원리(How to work) (2) | 2024.01.21 |

| Generative Adversarial Network (GAN) 개념 (2) | 2024.01.21 |

댓글